Програмата за защита на заплатите (PPP) се прилага от федералното правителство на САЩ, за да осигури пряк стимул за бизнеса да задържи служителите си на заплати, особено по време на пандемията Covid-19. ПЧП помага на квалифицираните фирми да запазят работната си сила, както и да плащат свързаните бизнес разходи. Данните от уебсайта на Министерството на финансите на САЩ показват кои компании са получили заеми за ПЧП и колко работни места са запазени. Министерството на финансите на САЩ одобри приблизително един милион заеми за ПЧП в САЩ.

Анализът на тези данни поставя три предизвикателства. Първо, размерът на данните е значителен. Времето за изтегляне, подреждане, трансформиране, извличане и докладване на тези данни е интензивно. Второ, наборът от данни вероятно ще се развива, което ще отнеме допълнително време и ресурси за разработка. И накрая, в многоетапен процес като този има шанс нещата да се счупят. Възможността за бързо определяне на грешки или тесни места ще помогне за последователно спазване на SLA.

Този блог илюстрира как Cloudera Data Engineering (CDE), използвайки Apache Spark, може да се използва за създаване на отчети въз основа на PPP данни, като същевременно се справя с всяко от предизвикателствата, описани по-горе.

Цел

По-долу е създаден фалшив сценарий за Съвета за законодателен бюджет на Тексас (LBB), за да помогне на инженер по данни да управлява и анализира данните за ПЧП. Основната цел на този инженер по данни е да предостави на LBB два крайни отчета:

- Доклад 1:Разбивка на всички градове в Тексас, които са запазили работни места

- Доклад 2:Разбивка на типа компания, която е запазила работни места

Cloudera Data Engineering (CDE)

Тук може да помогне Cloudera Data Engineering (CDE), работещ с Apache Spark. CDE е една от услугите в Cloudera Data Platform (CDP), която позволява на инженерите на данни да създават, управляват и планират задания на Apache Spark, като същевременно предоставят полезни инструменти за наблюдение на изпълнението на заданията, достъп до регистрационни файлове и оркестриране на работни потоци чрез Apache Airflow. Apache Spark е рамка за обработка на данни, която е в състояние бързо да изпълнява мащабна обработка на данни.

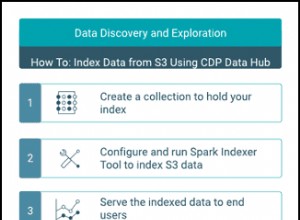

Министерството на финансите на САЩ предоставя два различни набора от данни, един за одобрени заеми над $150k и един за одобрени заеми под $150k. За да се изготвят двата крайни отчета за LBB, бяха последвани тези стъпки (вижте Фиг. 1).

- Първата стъпка беше да заредите двата отделни набора от данни в S3 кофа.

- За всеки набор от данни беше създадено задание Spark за изтегляне и филтриране на данни от кошчето S3.

- Тези две задания на Spark трансформираха и заредиха чистите данни в хранилище за данни на Hive за извличане.

- Беше създадено трето задание на Spark за обработка на данните от хранилището за данни на Hive за създаване на двата отчета.

След като изпълнението на заданието приключи, CDE предостави графично представяне на различните етапи във всяко задание на Spark (виж Фиг. 2). Това позволи на инженера по данни лесно да види кои части от работата потенциално отнемат най-много време, което им позволява лесно да прецизират и подобрят кода си, за да отговарят най-добре на SLA на клиентите.

Фиг. 1:Пътуване на данни за създаване на двата крайни отчета.

Фиг. 2:CDE графично представяне на различни етапи на Spark.

Резултати

Основната цел за изготвяне на двата крайни доклада от записа на милион одобрени кандидати беше постигната. Графичното обобщение на първия доклад (виж фиг. 3) показва извадка от топ 10 на броя на запазените работни места за град в Тексас, а вторият отчет (виж фиг. 4) показва извадка от топ 5 на броя на запазените работни места по тип фирма. С тези доклади Съветът за законодателен бюджет на Тексас, например, може да заключи, че градовете с най-малко задържани работни места на глава от населението може да се нуждаят от ресурси, за да намалят икономическото въздействие.

Фиг. 3:Топ 10 града, запазили най-много работни места, щат Тексас, 2020 г.

Фиг. 4:Топ 5 типа компании, които са запазили най-много работни места, щат Тексас, 2020 г.

Следващи стъпки

За да видите всичко това в действие, моля, кликнете върху връзките по-долу към няколко различни източника, показващи създадения процес.

- Видео – Ако искате да видите и чуете как е построено, вижте видеоклипа на връзката.

- Уроци – Ако искате да направите това със свое собствено темпо, вижте подробно ръководство с екранни снимки и инструкции ред по ред за това как да настроите и изпълните това.

- Среща – Ако искате да говорите директно с експерти от Cloudera, моля, присъединете се към виртуална среща, за да видите презентация на живо. В края ще има време за директни въпроси и отговори.

- Страница за потребители на CDP – За да научите за други CDP ресурси, създадени за потребители, включително допълнителни видеоклипове, уроци, блогове и събития, кликнете върху връзката.