В този урок за Hadoop ще обсъдим 10 най-добри характеристики на Hadoop. Ако не сте запознати с Apache Hadoop, можете да се обърнете към нашето Въведение в Hadoop блог, за да получите подробни познания за рамката на Apache Hadoop.

В този блог ще разгледаме най-важните функции на Hadoop за големи данни, като отказоустойчивост на Hadoop, разпределена обработка в Hadoop, мащабируемост, Надеждност, Висока наличност, икономичност, гъвкавост, местност на данните в Hadoop.

Въведение в Hadoop

Hadoop е софтуерна рамка с отворен код, която поддържа разпределено съхранение и обработка на огромно количество набор от данни. Това е най-мощният инструмент за големи данни на пазара поради своите функции. Функции като отказоустойчивост, надеждност, висока наличност и др.

Hadoop предоставя-

- HDFS – Най-надеждният слой за съхранение в света

- MapReduce – Слой за разпределена обработка

- ПРЕЖДА – Слой за управление на ресурсите

Важни характеристики на Hadoop за големи данни

Има толкова много функции, които Apache Hadoop предоставя. Нека обсъдим подробно тези функции на Hadoop.

a. Отворен код

Това е програмна рамка с отворен код, базирана на Java. Отвореният код означава, че е свободно достъпен и дори ние можем да променим неговия изходен код според вашите изисквания.

б. Толерантност на грешки

Грешки в контрола на Hadoop в процеса на създаване на реплика. Когато клиентът съхранява файл в HDFS, Hadoop framework разделя файла на блокове. След това клиентът разпределя блокове от данни между различни машини, присъстващи в HDFS клъстер.

И след това създайте реплика на всеки блок на други машини, присъстващи в клъстера. HDFS по подразбиране създава 3 копия на блок на други машини, присъстващи в клъстера.

Ако някоя машина в клъстера се повреди или се повреди поради неблагоприятни условия. Освен това потребителят може лесно да получи достъп до тези данни от други машини.

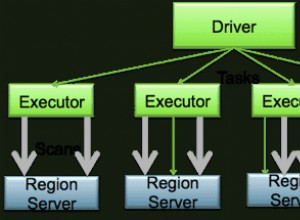

в. Разпределена обработка

Hadoop съхранява огромно количество данни по разпределен начин в HDFS. Обработвайте данните паралелно на клъстер от възли.

г. Мащабируемост

Hadoop е платформа с отворен код. Това го прави изключително мащабируема платформа. Така че нови възли могат лесно да се добавят без прекъсване. Hadoop осигурява хоризонтална мащабируемост, така че към системата е добавен нов възел в движение. В Apache hadoop приложенията работят на повече от хиляди възли.

д. Надеждност

Данните се съхраняват надеждно в клъстера от машини въпреки повреда на машината поради репликация на данни. Така че, ако някой от възлите се повреди, тогава също можем да съхраняваме надеждно данни.

f. Висока наличност

Поради множеството копия на данните, данните са високо достъпни и достъпни въпреки хардуерната повреда. Така че всяка машина се срива, данните могат да бъдат извлечени от другия път. Научете подробно функцията за висока достъпност на Hadoop.

ж. Икономически

Hadoop не е много скъп, тъй като работи на клъстера от стоков хардуер. Тъй като използваме евтин хардуер за стоки, не е необходимо да харчим огромна сума пари за мащабиране на вашия Hadoop клъстер.

i. Гъвкавост

Hadoop е много гъвкав по отношение на способността да се справя с всички видове данни. Той се занимава със структурирани, полуструктурирани или неструктурирани.

j. Лесен за използване

Няма нужда от клиент, който да се занимава с разпределени изчисления, рамката се грижи за всички неща. Така че е лесен за използване.

k. Местоположение на данни

Отнася се до способността да се премести изчислението близо до мястото, където действителните данни се намират на възела. Вместо преместване на данни към изчисление. Това минимизира претоварването на мрежата и увеличава свръхпропускателната способност на системата. Научете повече за Местоположение на данните.

Заключение

В заключение можем да кажем, че Hadoop е силно устойчив на грешки. Той надеждно съхранява огромно количество данни въпреки хардуерната повреда. Той осигурява висока мащабируемост и висока наличност.

Hadoop е рентабилен, тъй като работи на клъстер от стоков хардуер. Hadoop работи върху локализиране на данни, тъй като преместването на изчисленията е по-евтино от преместването на данни. Всички тези функции на Big data Hadoop го правят мощен за обработка на големи данни.