Дигиталната трансформация е гореща тема за всички пазари и индустрии, тъй като осигурява стойност с експлозивни темпове на растеж. Имайте предвид, че индустриалният Интернет на нещата (IIOT) на Manufacturing е оценен на 161 милиарда долара с впечатляващ темп на растеж от 25%, пазарът на свързани автомобили ще бъде оценен на 225 милиарда долара до 2027 г. с темп на растеж от 17%, или този през първите три месеца на 2020 г. търговците на дребно реализираха десет години навлизане в дигиталните продажби само за три месеца. Повечето от написаното обаче е свързано с позволяващите технологични платформи (облачни или крайни или точкови решения като складове за данни) или случаи на използване, които водят до тези предимства (предсказуем анализ, приложен към превантивна поддръжка, откриване на измами на финансова институция или прогнозен здравен мониторинг като примери) не основните данни. Липсващата глава не е за точкови решения или за зрелостта на случаите на употреба. Липсващата глава е за данните – винаги става дума за данните – и най-важното е, че данните за пътуването се преплитат от ръба до прозрението на изкуствения интелект.

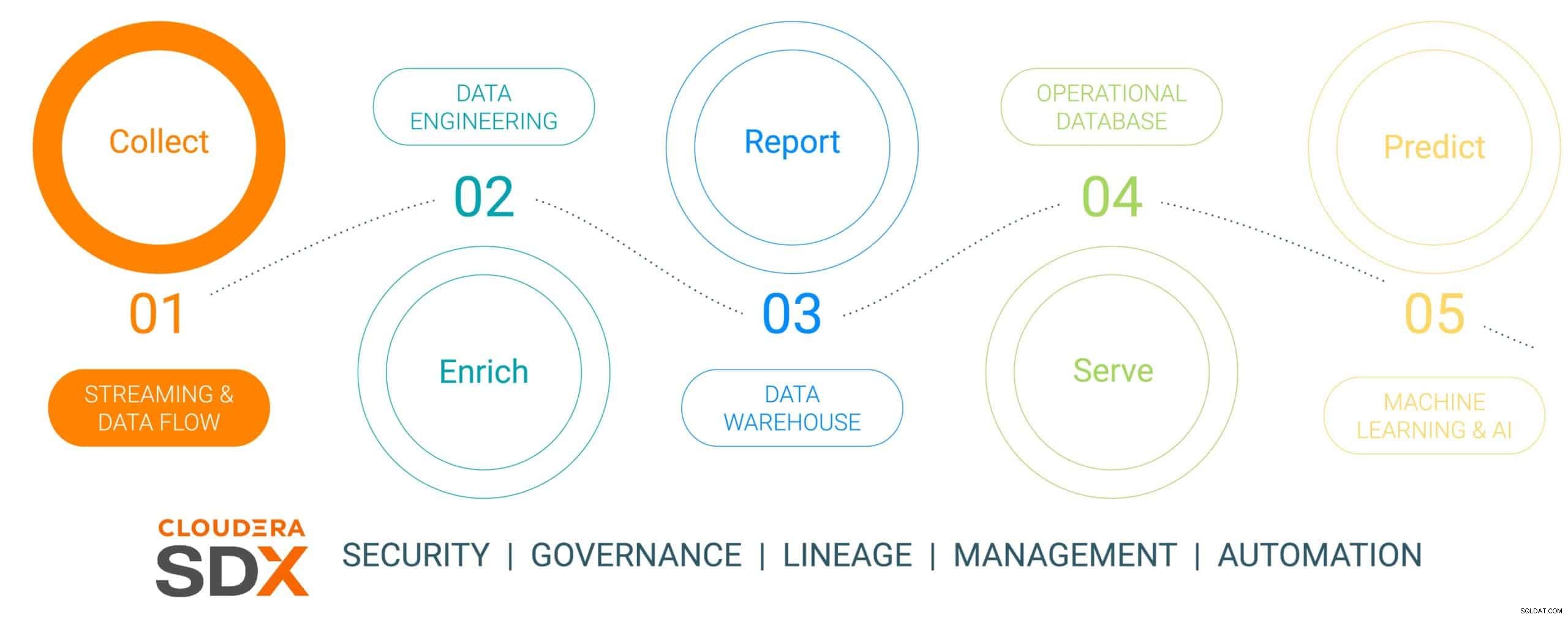

Това е първият от поредица от блогове от шест части, която очертава пътуването с данни от край до AI и данните за бизнес стойността, които създават по време на пътуването. Пътуването на данните не е линейно, но представлява безкраен цикъл на жизнения цикъл на данните – започващ на ръба, плетен през платформа за данни и в резултат на бизнес императивни прозрения, приложени към реални критични за бизнеса проблеми, които водят до нови инициативи, водени от данни. Опростихме това пътуване в пет отделни стъпки с обща шеста стъпка, говореща за сигурността и управлението на данните. Шестте стъпки са:

- Събиране на данни – поглъщане на данни и наблюдение на ръба (независимо дали ръбът е индустриални сензори или хора в магазин за търговия на дребно)

- Обогатяване на данни – обработка на тръбопровод на данни, агрегиране и управление за подготовка на данните за по-нататъшно прецизиране

- Отчитане – предоставяне на представа за бизнес предприятието (анализ и прогнозиране на продажбите, проучване на пазара, бюджетиране като примери)

- Обслужване – контролиране и управление на основни бизнес операции (транзакции на банкомат, плащане на дребно или наблюдение на производството)

- Предсказуем анализ – прогнозен анализ, базиран на AI и машинно обучение (откриване на измами, прогнозна поддръжка, оптимизация на инвентара въз основа на търсенето като примери)

- Сигурност и управление – интегриран набор от технологии за сигурност, управление и управление през целия жизнен цикъл на данните

Фигура 1:Жизненият цикъл на корпоративните данни

За да илюстрираме пътуването с данни, избрахме една много уместна и устойчива производствена тема – производството на електрически автомобил, избрана, защото производствените операции обикновено са революционни по природа (висока цифрова зрялост, внедряваща най-актуалните инструменти за данни) , в сравнение с „еволюционните от старата школа“ (с по-ниска зрялост) и че повечето от тези автомобили са построени като платформи за свързана мобилност, което прави колата повече от просто транспорт, а платформа за знания и прозрение, базирани на данни. Тази история ще покаже как данните се събират, обогатяват, съхраняват, обслужват и след това се използват за прогнозиране на събития в производствения процес на автомобила с помощта на Cloudera Data Platform.

Тази история ще включва фалшива свързана компания за производство на електрически превозни средства, наречена (с много оригинално име на) The Electric Car Company (ECC). ECC управлява множество производствени фабрики, разположени по целия свят, вертикално интегрирана е, изграждайки собствени автомобили, както и много от критичните компоненти, включително електрически двигатели, батерии и спомагателни части. Всяка фабрика е натоварена с производството на различни компоненти, като окончателното сглобяване се извършва в няколко избрани, стратегически разположени фабрики.

Предизвикателство за събиране на данни

Управлението на събирането на всички данни от всички фабрики в производствения процес е важно начинание, което представлява няколко предизвикателства:

- Трудност при оценката на обема и разнообразието от IoT данни: Много фабрики използват както съвременни, така и наследени производствени активи и устройства от множество доставчици, с различни протоколи и формати на данни. Въпреки че контролерите и устройствата могат да бъдат свързани към OT система, те обикновено не са свързани по начин, по който могат лесно да споделят данните и с ИТ системи. За да даде възможност за свързано производство и нововъзникващи случаи на използване на IoT, ECC се нуждае от решение, което може да обработва всички видове различни структури от данни и схеми от периферията, да нормализира данните и след това да ги споделя с всеки тип потребител на данни, включително приложения за големи данни.

- Управление на сложността на данните в реално време: За да може ECC да управлява случаи на използване на предсказуем анализ, платформата за управление на данни трябва да даде възможност за анализ в реално време на поточни данни. Платформата също така трябва ефективно да поглъща, съхранява и обработва поточните данни в реално време или почти реално време, за да предостави незабавно прозрения и действия.

- Освобождаване на данни от независими силози: Специализираните процеси (иновационни платформи, QMS, MES и др.) в рамките на производствената верига на стойност възнаграждават различни източници на данни и платформи за управление на данни, които са приспособени към уникални отделни решения. Тези нишови решения ограничават стойността на предприятието, като се има предвид само част от прозренията, които могат да предложат данните от различни предприятия, като същевременно разделят бизнеса и ограничават възможностите за сътрудничество. Правилната платформа трябва да има способността да приема, съхранява, управлява, анализира и обработва поточни данни от всички точки във веригата на стойността, да ги комбинира с Data Historians, ERP, MES и QMS източници и да ги използва в полезна информация. Тези прозрения ще предоставят табла за управление, отчети и прогнозни анализи, които управляват случаи на използване в производството с висока стойност.

- Балансиране на ръба: Разбирането на правилния баланс между обработката на данни на периферията и в облака е предизвикателство и ето защо трябва да се вземе предвид целият жизнен цикъл на данните. В индустрията има тревожна тенденция, тъй като компаниите избират да се фокусират върху едното или другото, без да осъзнават, че могат и трябва да правят и двете. Облачните изчисления имат своите предимства за дългосрочен анализ и широкомащабно внедряване, но са ограничени от честотната лента и често събират огромни количества данни, като използват само малка част. Стойността на ръба се състои в това да действа на ръба, където има най-голямо въздействие с нулева латентност, преди да изпрати най-ценните данни в облака за по-нататъшна високопроизводителна обработка.

Събиране на данни с помощта на Cloudera Data Platform

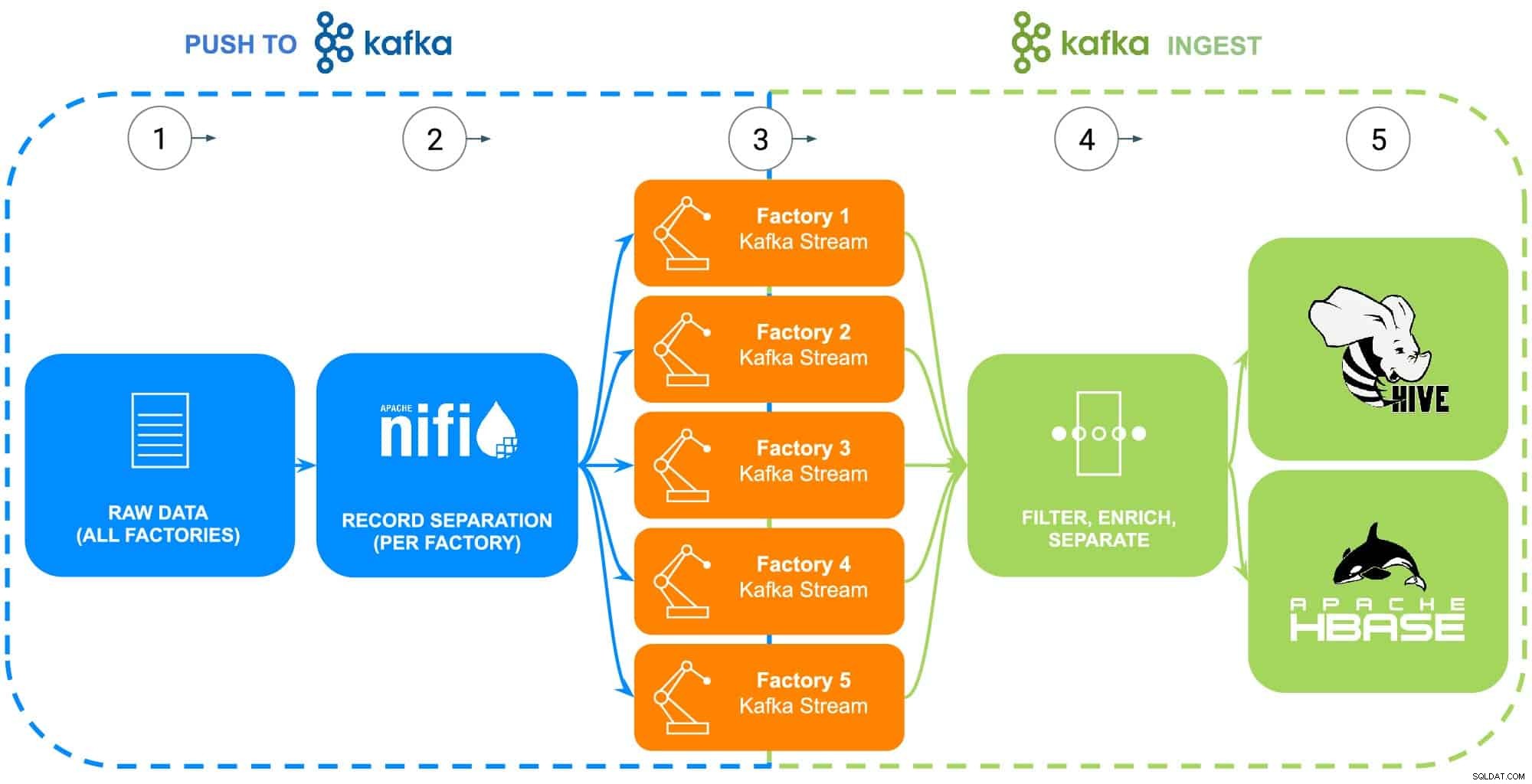

СТЪПКА 1:Събиране на необработените данни

Данните от производствената операция на ECC обхващат множество източници – промишлени роботи, технологични резервоари с фосфатно покритие с тяло в бяло (температура, концентрация или попълване), телематика на веригата за доставки или информация за основната част и т.н. За този конкретен пример, необработената част Основните данни за всяка от петте фабрики на ECC са събрани в подготовка за подаване на Apache NiFi (вижте Фигура 2).

СТЪПКА 2:Конфигуриране на източници на данни за всяка фабрика

Събирането на данни ще бъде илюстрирано с помощта на Data Flow опит на Cloudera (захранван от Apache NiFi), за да се извлекат тези необработени данни и да се разделят на отделни фабрични потоци (управлявани от Apache Kafka), за да приличат по-точно на сценарий от реалния свят (вижте Фигура 2). За да бъде примерът прост, следните маркери за атрибути на данни бяха избрани за всяка част, генерирана от фабриките:

- Фабричен номер

- Идент. № на машината

- Произведено времеви печат

- Номер на част

- Сериен номер

Фигура 2:Диаграма на потока за събиране на данни.

СТЪПКА 3:Следете пропускателната способност на данните от всяка фабрика

С всички данни, които сега се вливат в отделни потоци на Kafka, архитектът на данни наблюдава пропускателната способност на данните от всяка фабрика, както и коригира изчислителните и съхраняващи ресурси, необходими, за да се увери, че всяка фабрика има необходимата пропускателна способност за изпращане на данни в платформата.

СТЪПКА 4:Заснемане на данни от потоци на Apache Kafka

Kafka улавя всички потоци от фабрични данни и ги събира в процесори, които едновременно ще филтрират и обогатят за използване при контролиране и управление на основни бизнес операции, захранвани от оперативна база данни, или предоставяне на информация за бизнес предприятието чрез хранилище за корпоративни данни или използвани в разширени анализи.

ECC наскоро започна производството на модернизирана версия на техния електродвигател, който се произвежда само във Фабрика 5, тези данни ще бъдат използвани като илюстрация на следващите стъпки в жизнения цикъл на данните

СТЪПКА 5:Изпратете данни към решения за съхранение

Тъй като инженерите по производството и качеството на ECC ще искат да наблюдават отблизо внедряването и използването на този двигател на място, данните за специфичните производствени проследимости се филтрират в отделен маршрут и се записват в собствена таблица в Apache Hive. Това ще позволи на инженерите да изпълняват ad hoc заявки в Cloudera Data Warehouse спрямо данните по-късно, както и да ги присъединят към други подходящи данни в хранилището за данни на предприятието, като поръчки за ремонт или обратна връзка от клиенти, за да произвеждат случаи на предварителна употреба като гаранция, прогнозиране рутинни процедури за поддръжка или принос за разработване на продукти.

Като алтернатива, ако желаете да контролирате и изпълнявате основни бизнес операции, целият набор от данни с добавяне на обработено времеви печат ще бъде изпратен в оперативната база данни Cloudera, захранвана от Apache HBase. Тези данни ще служат като основа за ECC да стартира тяхната платформа за инвентаризация, което ще изисква използването на постоянни операции за четене/запис, тъй като инвентаризацията може да се добавя и премахва хиляди пъти на ден. Тъй като HBase е проектиран да обработва тези видове транзакции с данни в голям мащаб, той служи като най-доброто решение за това уникално предизвикателство.

Заключение

Тази проста илюстрация показва важността на правилното поглъщане на данни, тъй като е основополагаща за прозренията, предоставени както от оперативни бази данни, от корпоративни хранилища за данни, така и от усъвършенствани аналитични прогнозни анализи за машинно обучение. Стойността на „да се оправи“ включва използването на данни от всеки корпоративен източник, като по този начин се разбиват силозите за данни, използване на всички данни, независимо дали са стрийминг или пакетно ориентирани, и възможността да се изпращат тези данни на правилното място, създавайки желаната представа за низходящ поток.

Използвайки CDP, инженерите на ECC данни и други бизнес потребители могат да започнат да използват събраните данни за различни задачи, вариращи от управление на инвентара до прогнозиране на части до машинно обучение. Тъй като Cloudera Data Flow насърчава приемането на данни в реално време от всеки корпоративен източник, той може да бъде разширен и поддържан без обширни познания по различни езици за програмиране и собствени методологии за събиране на данни. Ако се сблъскат с уникални проблеми, инженерите могат също да създадат свои собствени процеси за истински, фино-зърнест контрол.

Потърсете следващия блог, който ще се задълбочи в обогатяването на данни и как то поддържа историята на жизнения цикъл на данните. В допълнение, тази история ще бъде допълнена с управлявани от данни демонстрации, показващи пътуването на данните през всяка стъпка от жизнения цикъл на данните.

Още ресурси за събиране на данни

За да видите всичко това в действие, моля, кликнете върху свързаните връзки по-долу, за да научите повече Събиране на данни:

- Видеоклип – Ако искате да видите и чуете как е построено, вижте видеоклипа на връзката.

- Уроци – Ако искате да правите това със собствено темпо, вижте подробно ръководство с екранни снимки и инструкции ред по ред за това как да настроите и изпълните това.

- Среща – Ако искате да говорите директно с експерти от Cloudera, моля, присъединете се към виртуална среща, за да видите презентация на живо. В края ще има време за директни въпроси и отговори.

- Потребители – За да видите повече техническо съдържание, специфично за потребителите, щракнете върху връзката.