ПравНЕ използвайте индекси с изключение на уникален единичен цифров ключ.

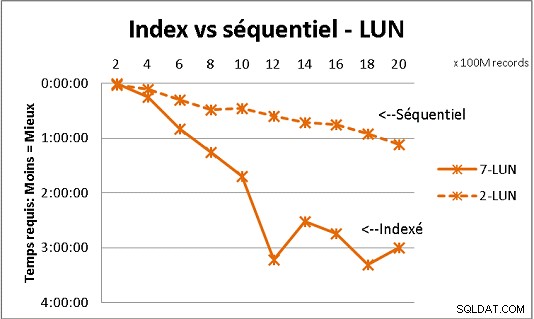

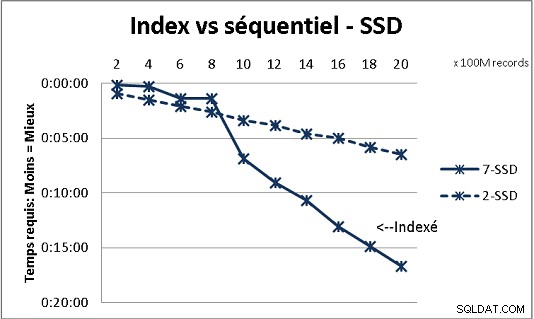

Това не се вписва в цялата теория на DB, която получихме, но тестването с голямо количество данни го демонстрира. Ето резултат от 100 милиона зареждания наведнъж за достигане на 2 милиарда реда в таблица и всеки път куп различни заявки в получената таблица. Първа графика с 10 гигабита NAS (150MB/s), втора с 4 SSD в RAID 0 (R/W @ 2GB/s).

Ако имате повече от 200 милиона реда в таблица на обикновени дискове, ще бъде по-бързо, ако забравите индексите. При SSD лимитът е 1 милиард.

Правил съм го и с дялове за по-добри резултати, но с PG9.2 е трудно да се възползвате от тях, ако използвате съхранени процедури. Също така трябва да се погрижите за запис/четене само на 1 дял наведнъж. Въпреки това, дяловете са начинът да запазите масите си под стената от 1 милиард реда. Също така помагамного за многопроцесорна обработка на вашите товари. Със SSD, един процес ми позволява да вмъкна (копирам) 18 000 реда/s (с включена част от обработката). С многопроцесорна обработка на 6 CPU, тя нараства до 80 000 реда/сек.

Наблюдавайте използването на CPU и IO, докато тествате, за да оптимизирате и двете.