Забележка:Тази статия първоначално беше изготвена през 2015 г., но беше актуализирана през 2019 г., за да отрази новата интеграция между IRI Voracity и Knime (за Konstanz Information Miner), сега най-мощната налична платформа за извличане на данни с отворен код.

Извличането на данни е науката за извличане на знания от данни, обикновено големи набори от данни, в които трябва да се открие смислена информация, тенденции и други полезни прозрения. Извличането на данни използва машинно обучение и статистически методи за извличане на полезни „късчета“ информация от това, което иначе би било много плашещ набор от данни.

Извличането на данни обхваща множество компютърни и математически дисциплини. Това не е толкова единен процес, колкото е общ термин за набор от действия. Четири общи задачи, които се изпълняват по време на копаене, включват: проучвателен анализ на данни (EDA), описателно моделиране, прогнозно моделиране и откриване на модели.

EDA използва конвенционални методи за статистическа визуализация или нетрадиционни графични методи, за да види дали в данните може да се намери нещо интересно.

При описателното моделиране данните се предават на рутина и се получават глаголи (генератори на данни) или прилагателни (описания на данни), които стоят зад формирането на данните. Това включва методи, които свързват данните с разпределение на вероятностите, групиране и моделиране на зависимости.

Прогнозното моделиране използва методи за регресия и класификация, за да създаде стандарт за прогнозиране на бъдещи неизвестни точки от данни. Регресията е чисто математически анализ, който напасва уравнение към набор от данни, за да предскаже следващата стойност. Прогнозното моделиране може също да разчита на шаблонни правила и връзки (или дори конкретно идентифицирани причинно-следствени тенденции), които са открити с помощта на метода за логически анализ на данни (LAD).

Откриването на модели чрез LAD класифицира нови наблюдения според предишни класификации на наблюденията и използва оптимизационни, комбинаторни и булеви функции за подобряване на точността на анализа.

В по-голямата си част тези методи могат само да посочат кои въведени данни са свързани, но не и причините или как са свързани. Възможно е да се обясни какво характеризира един клас/клъстер от друг чрез намиране на тези правила или модели, като темите са изброени по различни начини в зависимост от самите данни.

Приложенията за извличане на данни могат да варират от бизнес маркетинг до медицина, от откриване на измами в банкирането и застраховането до астрономия, от управление на човешки ресурси до индустрията за маркетинг на каталоги и т.н. Медицинската професия го намери за полезно за разграничаването на характеристиките на хора с различна степен на прогресия на заболяването. Магазините за търговия на дребно сега използват извличане на данни, за да разберат по-добре навиците на потребителските разходи, като отбелязват кои артикули се купуват заедно и тяхната връзка, както и най-добрия начин за рекламиране на своите клиенти. И голяма част от корпоративния свят сега разчита на извличане на данни за изчисляване, изпълнение и обосноваване на важни бизнес решения.

Въпреки това, както вече всички знаят от неотдавнашното интензивно медийно отразяване на скандала с телефонните записи на NSA-Verizon, извличането на данни също може да бъде изключително противоречиво. Само в случай, че сте живели под камък, ето кратък синопсис:

На 5 юни 2013 г. британският всекидневник, наречен The Guardian, публикува ексклузивен доклад, че милиони клиентски записи от Verizon, един от най-големите телекомуникационни доставчици в САЩ, са били събрани от Агенцията за национална сигурност на САЩ в отговор на класифицирана заповед от Съда за наблюдение на външното разузнаване на САЩ. Бизнес мрежовите услуги на Verizon бяха принудени да предадат всички метаданни за телефония, създадени от доставчика на мобилни услуги в САЩ и в чужбина. В резултат на това, двупартийна и универсална критика към администрацията на Обама след това избухна от групи за застъпничество за граждански права и новинарски медии, твърдейки, че президентът злоупотребява с изпълнителната власт. Не се вижда решение на този инцидент към написването на тази статия. Но несъмнено ще остане отличен пример за това как извличането на данни понякога може да се разглежда в негативна светлина, особено по отношение на опасенията за поверителността и широката общественост.

Когато работите с големи обеми статични или динамични данни, със сигурност ще има проблеми с производителността, свързани с изчисленията и I/O. С бази данни, съдържащи терабайти и ексабайти данни, разресването на данните може да отнеме много време, а алгоритмите за копаене трябва да работят много ефективно. Някои други трудности включват прекомерно монтиране и шумни данни.

Прекомерното оборудване обикновено означава, че няма достатъчно добри данни. Моделът на данните (в този случай глобалното описание на данните) става твърде сложен, тъй като има твърде много параметри спрямо броя на наблюденията. Това преувеличава малките колебания в данните, като по този начин компрометира надеждността на модела като основа за правене на прогнози.

Шумните данни, от друга страна, се отнасят до твърде много от грешен вид данни. Безсмислените, погрешните, неструктурирани (нечетими) или по друг начин повредени данни увеличават изискванията за съхранение и/или изискват статистически анализ да бъде отстранен, преди да може да попречи на точността на извличане на данни. Добрите алгоритми за извличане на данни вземат предвид шумните данни.

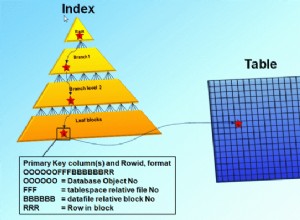

Извличането на данни е една стъпка в по-голям процес, известен като откриване на знания в бази данни (KDD). KDD първо започва с подготовката на данните: избор, предварителна обработка и трансформация на данните, където определяте какво искате да изучавате и го настройвате по начин, който може да бъде копано. Това е представяне на данните като m-n матрица и с числово представяне на елемента на всеки вектор от данни. След това ти моя. И накрая, можете да използвате стария noggin, за да интерпретирате и анализирате тази информация. След това, ако скритите модели и тенденции все още не са достатъчно ясни, трябва да копаете малко по-дълбоко.

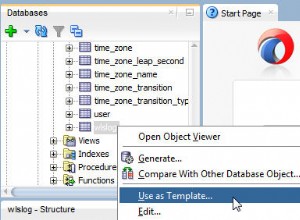

Ролята на IRI в процеса на извличане на данни и KDD е да подготвя и преструктурира големи данни за анализ чрез множество високоефективни функции за преобразуване на данни. По-конкретно, пакетът за манипулиране на данни на IRI CoSort може бързо да филтрира, манипулира и преформатира данните, така че да могат да бъдат обработени от алгоритми за извличане на данни като тези софтуерни пакети за извличане на данни. CoSort е също така машината за обработка на данни по подразбиране в платформата за управление на данни IRI Voracity, предназначена за широк спектър от профилиране, подготовка и работа по спорове.

За тези, които работят с CoSort в графичния интерфейс на IRI Workbench, BIRT е безплатен плъгин за Eclipse с възможности за графично отчитане и бизнес разузнаване, които включват някои функции за анализ и копаене. И CoSort, и BIRT Analytics използват Eclipse IDE. С поддръжката на драйвери за данни за отворен достъп до данни (ODA), преминаваща в CoSort, интеграцията на потока от данни между двете добавки също е безпроблемна и позволява по-бързи анализи какво-ако.

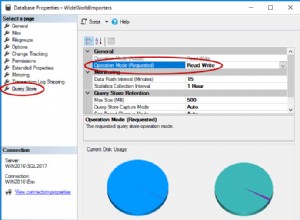

За тези, които работят с Voracity през 2019 г. и след това, предлагаме да инсталират основния доставчик за безплатната Knime Analytics Platform в IRI Workbench. В същия стъклен панел на Eclipse, възелът източник (доставчик) на Voracity за Knime може да го предаде подготвените от Voracity необработени данни в паметта на възлите на Knime за приложения, изискващи статистически и прогнозивен анализ, извличане на данни и машинно/дълбоко обучение, невронна мрежа и изкуствен интелект.

Участниците в тази статия включват Роби Пото и Дейвид Фридланд