Проблемът може да е в различни версии на Avro в Hadoop на Dataproc (Avro 1.7.7) и Sqoop 1.4.7 (Avro 1.8.1).

Може да опитате да понижите Sqoop до 1.4.6, който зависи от Avro 1.7 и да използвате avro-tools-1.7.7.jar по време на изпращане на работа.

Редактирано:

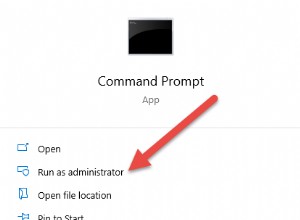

За да разрешите проблема със зареждането на класове, трябва да зададете mapreduce.job.classloader=true при подаване на задание на Dataproc:

gcloud dataproc jobs submit hadoop --cluster=<CLUSTER_NAME> \

--class=org.apache.sqoop.Sqoop \

--jars=gs://<BUCKET>/sqoop-1.4.7-hadoop260.jar \

--properties=mapreduce.job.classloader=true \

-- \

. . .