Така че гледате някъде от района на 100 милиарда записа (1 милион записа * 100 000 потребители).

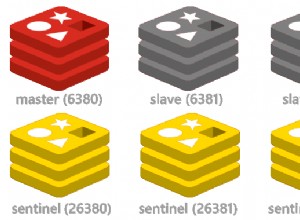

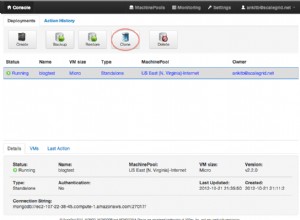

Предпочитаният начин за работа с големи количества данни е да се създаде сегментиран клъстер, който разделя данните на няколко сървъра, които се представят като една логическа единица чрез mongo клиента.

Следователно отговорът на вашия въпрос е да поставите всичките си записи в една шардирана колекция.

Броят на необходимите сегменти и конфигурацията на клъстера са свързани с размера на данните и други фактори като количеството и разпределението на четенията и записите. Отговорите на тези въпроси вероятно са много специфични за вашата уникална ситуация, така че няма да се опитвам да ги отгатвам.

Вероятно бих започнал, като реша с колко фрагмента разполагате с времето и машините, за да настроите и тествате системата на клъстер от толкова много машини. Въз основа на ефективността на това можете да решите дали имате нужда от повече или по-малко фрагменти във вашия клъстер