Един от начините да перифразираме въпроса е да кажем дали заявка за 1 милион документи отнема повече време, ако документите са 16mb срещу 16kb всеки.

Поправете ме, ако греша, от моя собствен опит, колкото по-малък е размерът на документа, толкова по-бърза е заявката.

Правил съм заявки за 500 000 документа срещу 25 000 документа и заявката за 25 000 беше значително по-бърза - варираща от няколко милисекунди до 1-3 секунди по-бърза. При производство времевата разлика е около 2x-10x повече.

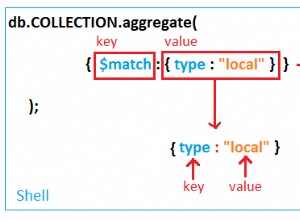

Единственият аспект, при който размерът на документа влиза в действие, е сортирането на заявки, в който случай размерът на документа ще повлияе дали самата заявка ще се изпълни или не. Достигнал съм това ограничение много пъти, опитвайки се да сортирам само 2k документа.

Още препратки с някои решения тук:https://docs.mongodb.org/manual /reference/limits/#operations https://docs.mongodb.org/ manual/reference/operator/aggregation/sort/#sort-memory-limit

В крайна сметка крайният потребител страда.

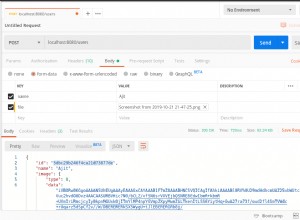

Когато се опитвам да коригирам големи заявки, причиняващи неприемливо бавна производителност. Обикновено установявам, че създавам нова колекция с поднабор от данни и използвам много условия на заявка заедно със сортиране и ограничение.

Надявам се това да помогне!