Фактът, че организациите са изправени пред предизвикателствата на Big Data, е често срещан в днешно време. Терминът Големи данни се отнася до използването на набор от множество технологии, стари и нови, за извличане на някаква значима информация от огромна купчина данни. Наборът от данни не само е голям, но има и свой собствен уникален набор от предизвикателства при тяхното улавяне, управление и обработка. За разлика от данните, съхранявани в релационни бази данни, които са структурирани, форматът за големи данни може да бъде структуриран, полуструктуриран до неструктуриран или събиран от различни източници с различни размери. Тази статия разглежда основните аспекти на големите данни, техните основни характеристики и ви дава намек за инструментите и техниките, използвани за справяне с тях.

Общ преглед

Терминът Големи данни дава впечатление само за размера на данните. Това в известен смисъл е вярно, но не дава цялата картина. Предизвикателствата, свързани с него, не са само в неговия размер. Всъщност идеята еволюира, за да назове море от данни, събрани от различни източници, формати и размери, и в същото време е трудно да се използва или да се извлече стойност от тях. Възходът на нововъзникващите технологии и нарастващото използване на интернет дадоха тласък на обема и несъответствието. Обемът продължава да се увеличава с всеки обмен на информация през Интернет или дори с малките IoT обекти, които използваме. Простото вдигане на телефонно обаждане или включване на CCTV може да генерира верига от данни. Днес повечето устройства са свързани онлайн. Сега, ако една организация иска да събира тази информация онлайн, тя се нуждае от специален процес на обработка, тъй като генерираните данни ще бъдат огромни. Освен това може да няма еднаквост във формата на заснетите данни. Това допълва сложността, тъй като трябва да работим със структурирани, полуструктурирани или неструктурирани данни. Инструментите, които използвахме досега за организиране на данни, не са в състояние да се справят с такова разнообразие и обем. Следователно можем да кажем, че терминът Големи данни всъщност се отнася за данните, които не могат да бъдат обработени или анализирани чрез традиционни инструменти и техники, които обикновено се използват за обработка на структурирани или полуструктурирани данни, като например използване на релационни бази данни, XML и така нататък.

Организациите днес са пълни с неструктурирани или полуструктурирани данни, налични в необработен формат. Тези данни могат да бъдат изобилие от информация, ако бъдат обработени и стойността, получена от тях. Но проблемът е как да го направя. Традиционните техники и инструменти, като релационни бази данни, са неадекватни за справяне с толкова голям обем разнообразни данни. Това също е проблем с две остриета за организациите, защото простото им раздробяване би означавало загуба на ценна информация — ако има такава — и запазването й е загуба на ресурси. Поради това се търсят някои инструменти и техники за справяне с проблема. Понякога сме напълно сигурни в потенциалната му стойност, която лежи в купчината и можем да извлечем златна мина от информация, но без подходящи инструменти е доста облагане за бизнес процеса да извлече някаква полза от това. Данните днес са масивни и експлодират като всичко през последните години; между другото изглежда няма да го спре.

Информационна експлозия

Големите данни стават все повече с всяка минута в почти всеки сектор, било то технологии, медии, търговия на дребно, финансови услуги, пътувания и социални медии, за да назовем само няколко. Обемът на обработка на данни, за който говорим, е умопомрачителен. Ето малко статистическа информация, която да ви даде представа:

- Каналите за времето получават 18 055 555 заявки за прогноза всяка минута.

- Потребителите на Netflix предават поточно 97 222 часа видео всяка минута.

- Потребителите на Skype извършват 176 220 обаждания всяка минута.

- Потребителите на Instagram публикуват 49 380 снимки всяка минута.

Тези цифри нарастват всяка година, като все повече хора използват интернет. През 2017 г. използването на интернет достигна до 47% (3,8 милиарда души) от населението на света. С непрекъснато нарастващия брой електронни устройства, нашите приблизителни изходни данни се оценяват на 2,5 квинтилиона байта на ден и нарастват.

Статистиката за търсене на Google показва 3,5 милиарда търсения на ден, което е средно над 40 000 търсения всяка секунда. Също така не бива да пропускаме, че други търсачки също правят търсения. Докладът за електронна поща за 2015-2019 г. на Radicati Group, Inc. показва 2,9 милиарда потребители на имейл до 2019 г.

В опит да се изчисли колко снимки ще бъдат направени през 2017 г.:Ако през 2017 г. имаше 7,5 милиарда души в света, като около 5 милиарда имаха мобилни телефони, вероятно предположението е, че 80% от тези телефони имат вградени камери. Това означава, че около 4 милиарда души използват своите камери. Ако правят по 10 снимки на ден, което възлиза на 3650 снимки годишно на човек, това добавя приблизително 14 трилиона снимки, правени годишно.

Следователно, когато казваме Big Data, това по същество се отнася до данни или набори от записи, които са твърде големи, за да бъдат предполагаеми. Те се произвеждат чрез търсачките, бизнес информатиката, социалните мрежи, социалните медии, геномиката, метеорологията, прогнозите за времето и много други източници. Това очевидно не може да се управлява с помощта на съществуващи инструменти и техники за управление на бази данни. Големите данни отварят арена на големи предизвикателства по отношение на съхранение, улавяне, управление, поддръжка, анализ, изследване, нови инструменти за справяне с тях и други подобни.

Характеристики на големите данни

Както при всички големи неща, ако искаме да ги управляваме, трябва да ги характеризираме, за да организираме нашето разбиране. Следователно големите данни могат да бъдат дефинирани от една или повече от трите характеристики, трите Vs:голям обем , високоразнообразие и висока скорост . Тези характеристики повдигат някои важни въпроси, които не само ни помагат да ги дешифрираме, но и дават представа как да се справяме с масивни, разнородни данни с управляема скорост в рамките на разумен период от време, така че да можем да извлечем полза от тях, да направим някои анализ в реално време и бързо предоставяне на последващ отговор.

- Обем: Обемът се отнася до големия размер на непрекъснато експлодиращите данни в компютърния свят. Това повдига въпроса за количеството данни.

- Скорост: Скоростта се отнася до скоростта на обработка. Това повдига въпроса с каква скорост се обработват данните.

- Разнообразие: Разнообразието се отнася до видовете данни. Това повдига въпроса колко различни са форматите на данни.

Имайте предвид, че ние характеризираме Big Data в три Vs, само за да опростим основните им принципи. Напълно възможно е размерът да бъде сравнително малък, но твърде пъстър и сложен, или да бъде сравнително прост, но огромен обем данни. Следователно, в допълнение към тези три V, можем лесно да добавим още едно, Reacity . Достоверността определя точността на данните по отношение на бизнес стойността, която искаме да извлечем. Без достоверност е невъзможно една организация да използва ресурсите си за анализиране на купчината данни. С по-голяма точност по отношение на контекста на данните има по-голям шанс за получаване на ценна информация. Следователно достоверността е друга характеристика на големите данни. Компаниите използват структурирани, полуструктурирани и неструктурирани данни от електронна поща, социални медии, текстови потоци и др. Но преди анализа е важно да се идентифицира количеството и видовете данни, които се вземат предвид, които биха повлияли на бизнес резултатите.

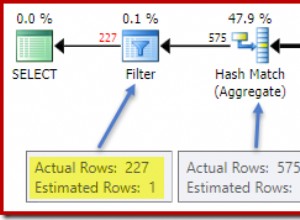

Инструменти и техники

Изкуственият интелект (AI), IoT и социалните медии управляват сложността на данните чрез нови форми и източници. Например, от решаващо значение е в реално време големите данни, идващи през сензори, устройства, мрежи, транзакции, да се улавят, управляват и обработват с ниска латентност. Големите данни позволяват на анализатори, изследователи и бизнес потребители по-бързо да вземат по-информирани решения, като използват исторически данни, които иначе са били недостижими. Човек може да използва анализ на текст, машинно обучение, прогнозен анализ, извличане на данни и обработка на естествен език, за да извлече нова информация от наличната купчина данни.

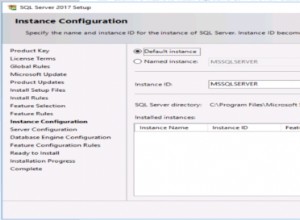

Технологията се е развила за управление на огромни обеми данни, които преди са били скъпи и е трябвало да имат помощта на суперкомпютри. С появата на социални медии като Facebook, търсачки като Google и Yahoo!, проектите за големи данни получиха тласък и се разраснаха, както е днес. Технологии като MapReduce, Hadoop и Big Table са разработени, за да отговорят на днешните нужди.

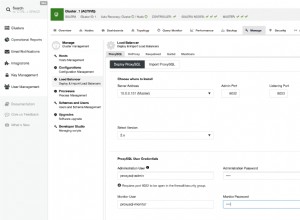

Хранищата на NoSQL също се споменават във връзка с Big Data. Това е алтернативна база данни за разлика от релационните бази данни. Тези бази данни не организират записи в таблици с редове и колони, както се намират в конвенционалните релационни бази данни. Има различни типове бази данни NoSQL, като Content Store, Document Store, Event Store, Graph, Key Value и други подобни. Те не използват SQL за заявки и следват различен архитектурен модел. Установено е, че те улесняват анализа на големи данни по благоприятен начин. Някои популярни имена са:Hbase, MongoDB, CouchDB и Neo4j. Освен тях има много други.

Заключение

Големите данни отвориха нова възможност за събиране на данни и извличане на стойност от тях, които иначе бяха отпадъци. Невъзможно е да се улавят, управляват и обработват големи данни с помощта на традиционни инструменти като релационни бази данни. Платформата за големи данни предоставя инструментите и ресурсите за извличане на представа за обемните, разнообразни и бързи данни. Тези купчини данни вече имат средства и жизнеспособен контекст, които да се използват за различни цели в бизнес процеса на организация. Следователно, за да определим точно за какъв тип данни говорим, трябва да разберем тях и техните характеристики като основна стъпка.