Намерих това тук Групова миграция на данни чрез Spark SQL

Параметърът dbname може да бъде всяка заявка, обвита в скоби с псевдоним. Така че в моя случай трябва да направя това:

val query = """

(select dl.DialogLineID, dlwim.Sequence, wi.WordRootID from Dialog as d

join DialogLine as dl on dl.DialogID=d.DialogID

join DialogLineWordInstanceMatch as dlwim on dlwim.DialogLineID=dl.DialogLineID

join WordInstance as wi on wi.WordInstanceID=dlwim.WordInstanceID

join WordRoot as wr on wr.WordRootID=wi.WordRootID

where d.InSite=1 and dl.Active=1

limit 100) foo

"""

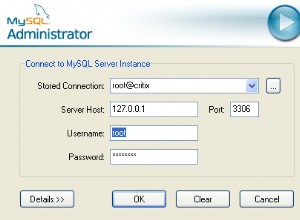

val df = sqlContext.format("jdbc").

option("url", "jdbc:mysql://localhost:3306/local_content").

option("driver", "com.mysql.jdbc.Driver").

option("useUnicode", "true").

option("continueBatchOnError","true").

option("useSSL", "false").

option("user", "root").

option("password", "").

option("dbtable",query).

load()

Както се очакваше, зареждането на всяка таблица като своя собствена рамка от данни и присъединяването им в Spark беше много неефективно.